Il n'est pas exagéré de dire que l'intelligence artificielle (IA) est aujourd'hui omniprésente. Il est impossible de se retourner ces jours-ci sans voir une nouvelle incarnation ou une nouvelle application de l'IA. C'est particulièrement vrai dans le monde de la production vidéo et cinématographique.

De l'écriture du scénario et du repérage des lieux en préproduction à la suppression d'objets et à la stabilisation de la scène en postproduction, la prise de contrôle de l'IA et de l'apprentissage automatique est bien réelle. Et c'est une bonne chose : moins de temps passé sur des tâches fastidieuses signifie que les professionnels du M&E peuvent économiser de l'argent et consacrer leur temps précieux à des tâches plus utiles.

Mais l'une des façons les plus innovantes et les plus puissantes dont le pouvoir de la L'IA révolutionne le monde de la vidéo se fait par l'intermédiaire de compréhension de la vidéo.

Cet article a été rédigé en partenariat avec Douze laboratoires, pionnier de l'IA multimodale pour la compréhension des vidéos. sur leur blog.

Table des matières

Transfert de fichiers pour des ensembles massifs de données

Le moyen le plus rapide et le plus simple de décharger de grands ensembles de données et de grands fichiers vidéo dans le nuage pour le traitement de l'IA.

Qu'est-ce que la compréhension vidéo ?

Compréhension de la vidéo analysent, interprètent et comprennent le contenu des vidéos, en extrayant les informations de manière à ce que le contexte entier de la vidéo soit compris.

Photo par Agence Olloweb sur Unsplash

Il ne s'agit pas seulement d'identifier des objets image par image ou d'analyser les composants audio. La compréhension des vidéos par l'IA permet d'associer le langage naturel aux actions dans une vidéo.. Pour ce faire, il doit effectuer diverses tâches de compréhension vidéo, telles que la reconnaissance d'activités et la détection d'objets, afin de saisir les nuances de ce qui est communiqué par le biais de ce média le plus fluide qui soit, en traitant et en comprenant les éléments visuels, sonores et vocaux d'une vidéo.

Il est également différent des grands modèles de langage (LLM) tels que ChatGPT, qui ne sont pas formés pour comprendre spécifiquement les données vidéo.

En d'autres termes, les modèles de compréhension vidéo de l'IA comprennent la vidéo de la même manière que nous.

C'est un défi de taille, mais c'est un défi que la société Twelve Labs, spécialisée dans l'infrastructure de compréhension vidéo, s'apprête à relever avec enthousiasme.

Intelligence artificielle et réalisation de films

Une exploration de l'impact de l'intelligence artificielle sur la réalisation de films et une analyse de la technologie.

Applications de la compréhension vidéo dans les médias et le divertissement

Avant de plonger dans la technologie qui sous-tend la compréhension approfondie de la vidéo, examinons comment la compréhension de la vidéo peut rationaliser le travail des professionnels du cinéma et de l'audiovisuel et des créateurs de contenu vidéo.

Recherche vidéo

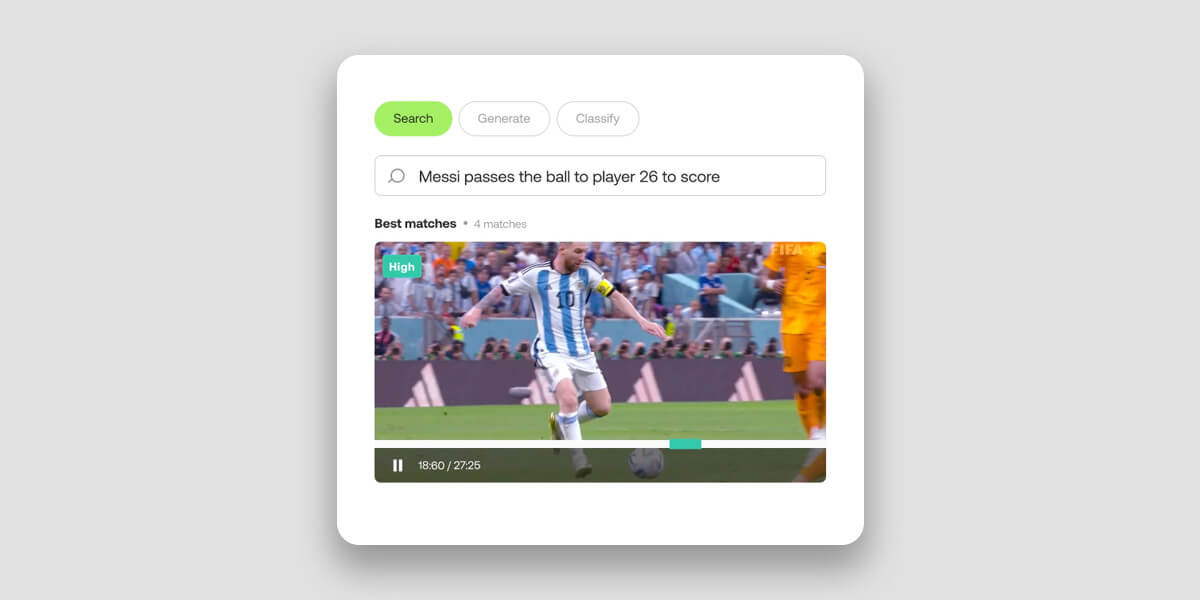

Imaginez que vous puissiez trouver une vidéo particulière dans une vaste collection de pétaoctets de données, simplement en décrivant ses éléments visuels en langage naturel. Ou comme un ligue ou club sportifen demandant à votre modèle de compréhension vidéo de l'IA de monter une bande-son de tous les buts d'un joueur en quelques secondes seulement.

Toutes ces choses sont possibles grâce à la compréhension des vidéos par l'IA.

La recherche vidéo traditionnelle, quant à elle, présente de sérieuses limites dans son approche et son exécution. En s'appuyant principalement sur la correspondance des mots-clés pour indexer et extraire les vidéos, elles ne tirent pas parti des techniques d'intelligence artificielle multimodales qui permettent de mieux comprendre la vidéo grâce à des indices visuels et auditifs.

En intégrant simultanément tous les types de données disponibles - y compris les images, les sons, la parole et le texte à l'écran - les modèles modernes de compréhension vidéo saisir les relations complexes entre ces éléments afin de fournir une interprétation plus nuancée et plus humaine.

Il en résulte une recherche et une récupération de vidéos beaucoup plus rapides et précises à partir du stockage d'objets dans le nuage. Au lieu de procéder à un étiquetage manuel fastidieux et inefficace, les monteurs vidéo peuvent utiliser le langage naturel pour effectuer des recherches rapides et précises dans de vastes archives multimédias afin de dénicher des moments vidéo et des joyaux cachés qui, autrement, passeraient inaperçus.

Douze laboratoires Recherche dans l'API prend environ 15 minutes pour indexer une heure de vidéo, rendant les vidéos indexées sémantiquement consultables dans plus de 100 langues.

Classification vidéo

La compréhension des vidéos par l'IA permet de classer automatiquement les vidéos dans des catégories ou des sujets prédéfinis. En utilisant le logiciel de Twelve Labs Classer l'APIVous pouvez classer les vidéos en sports, actualités, divertissements ou documentaires en analysant les caractéristiques sémantiques, les objets, les actions et d'autres éléments du contenu.

Le modèle peut également classer des scènes spécifiquesCette technologie peut permettre des applications pratiques dans le domaine de la publicité ou de la modération de contenu. La technologie peut identifier une scène contenant une arme comme étant éducative, dramatique ou violente, par exemple, en fonction du contexte.

Cela profite aux créateurs et aux plateformes vidéo, tout en améliorant l'expérience des utilisateurs grâce à des recommandations plus précises basées sur les intérêts et les préférences de l'utilisateur. Elle profite également aux professionnels de la post-production qui ont besoin de trouver et d'enregistrer rapidement des éléments à des fins de montage, d'archivage ou autres.

Bien que chaque vidéo utilisée dans le cadre de la technologie de Twelve Labs contienne des métadonnées standardLes utilisateurs ont également la possibilité d'ajouter métadonnées personnalisées à leurs vidéos pour fournir des informations plus détaillées ou spécifiques au contexte.

De la surveillance et de la sécurité à l'analyse sportive, de la modération de contenu à la publicité contextuelle, la compréhension de la vidéo a la capacité de bouleverser complètement la classification des vidéos.

Description de la vidéo

La compréhension de la vidéo permet de résumer automatiquement un ensemble de données vidéo grâce à des descriptions détaillées générées en quelques secondes. La technologie améliore la compréhension et l'engagement en condensant les longues vidéos en représentations concises qui capturent le contenu le plus important.

Ces résumés rapides et détaillés peuvent s'avérer très utiles pour enrichir les médias de métadonnées descriptives et de résumés. Notamment pour les personnes souffrant de handicaps physiques ou de déficiences cognitives qui font de la vidéo un support peu idéal.

Dans l'industrie des médias et du divertissement, la description et le résumé vidéo peuvent être utilisés pour créer des aperçus ou des bandes-annonces de films, d'émissions de télévision et d'autres contenus vidéo. Ces aperçus donnent un aperçu concis du contenu et aident les spectateurs à décider s'ils veulent regarder la vidéo dans son intégralité. Et tout ce qui améliore l'expérience de l'utilisateur est une bonne chose.

Douze laboratoires Générer une suite d'API génère des textes à partir de vos vidéos. Il offre trois points d'accès distincts conçus pour répondre à diverses exigences. Chaque point d'accès a été conçu avec des niveaux spécifiques de flexibilité et de personnalisation pour répondre à des besoins différents.

- Le site API Gist peut produire des textes concis tels que des titres, des sujets et des listes de hashtags pertinents.

- Le site Résumé de l'API est conçu pour générer des résumés vidéo, des chapitres et des points forts.

- Pour les sorties personnalisées, l'option Générer l'API permet aux utilisateurs de demander des formats et des styles spécifiques, des puces aux rapports et même des paroles créatives basées sur le contenu de la vidéo.

La technologie derrière la compréhension de la vidéo

"L'IA ne peut pas comprendre 80% des données mondiales parce qu'elle est enfermée dans le contenu vidéo", explique le PDG de Twelve Labs. Jae Lee dans une interview accordée à MASV. "Nous construisons les clés pour le déverrouiller.

En effet, les anciens modèles de vision par ordinateur (VA), qui utilisent des réseaux neuronaux et la ML pour comprendre les images numériques, ont toujours eu du mal à comprendre le contexte dans la vidéo. Les modèles de CV sont excellents pour identifier les objets et les comportements, mais pas les relations entre eux. C'est une lacune qui, jusqu'à récemment, limitait notre capacité à analyser avec précision le contenu vidéo à l'aide de l'IA.

Travis Couturearchitecte de solutions fondateur de Twelve Labs, a défini le problème comme étant celui du contenu par rapport au contexte.

"L'approche traditionnelle consiste à décomposer le contenu vidéo en problèmes plus faciles à résoudre, ce qui implique généralement d'analyser les images une par une, et de décomposer les canaux audio séparément et de les transcrire. Une fois ces deux processus terminés, on rassemble le tout et on combine les résultats.

"Quand on fait cela - briser et reconstruire -, il faut savoir que l'on ne peut pas se contenter d'une seule chose.vous avez peut-être le contenu, mais vous n'avez pas le contexte. Et avec la vidéo, le contexte est roi.

"L'objectif de Twelve Labs est de s'éloigner de l'approche traditionnelle de la vision par ordinateur pour entrer dans le domaine de la compréhension de la vidéo, ce qui signifie traiter la vidéo comme le font les humains, c'est-à-dire tous ensemble, en même temps.

Compréhension multimodale de la vidéo

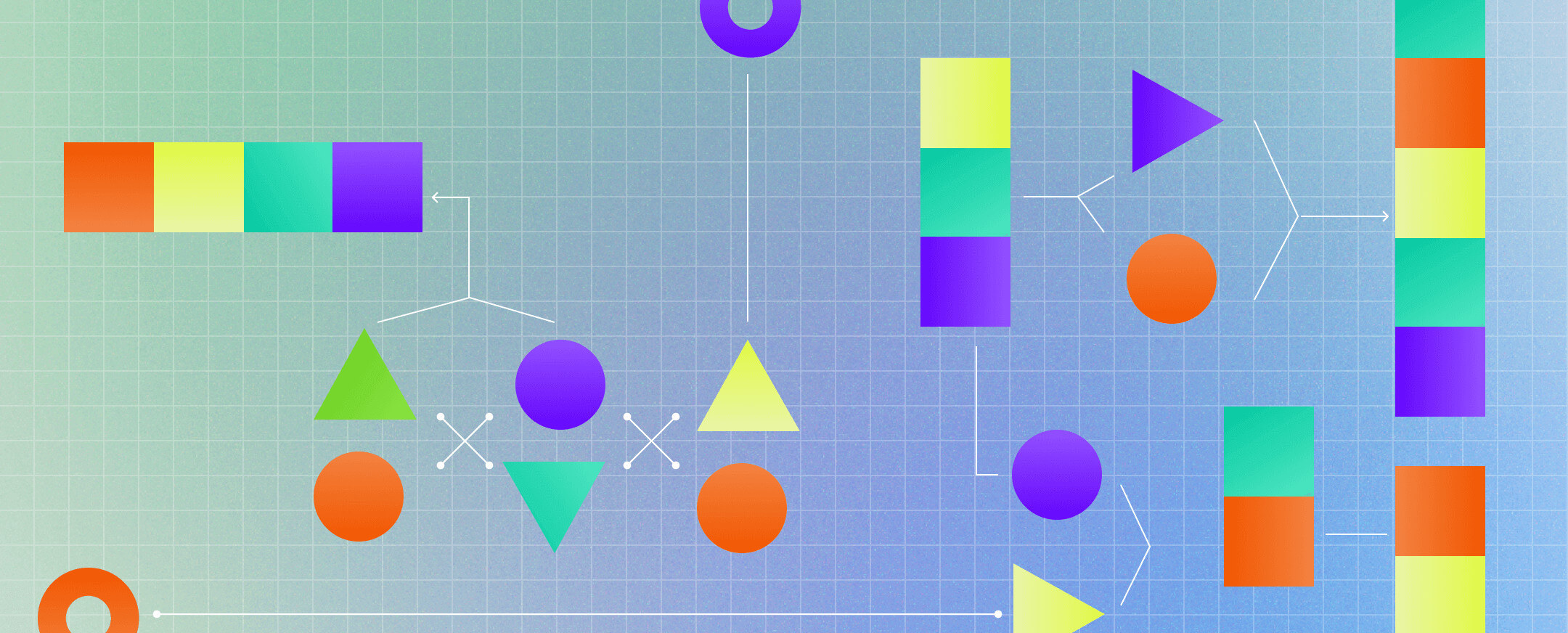

Source : Qu'est-ce que l'IA multimodale ?

La vidéo est dynamique, stratifiée, fluide - une combinaison d'éléments qui, lorsqu'ils sont décomposés et analysés séparément, ne forment pas un tout. C'est ce problème que Twelve Labs a résolu. Mais comment ont-ils fait ?

En employant IA multimodale.

Dans ce contexte, le terme "modalité" fait référence à la manière dont un événement est vécu. Avec la vidéo, comme dans le monde réel, il existe de multiples modalités : auditives, visuelles, temporelles, linguistiques et autres.

"Lorsque vous analysez ces modalités séparément et que vous essayez de les reconstituer", explique le cofondateur de Twelve Labs et responsable du développement commercial Soyoung LeeVous ne parviendrez jamais à une compréhension et à un contexte holistiques.

L'approche multimodale de Twelve Labs lui a permis de construire un modèle qui reproduit la manière dont les humains interprètent les vidéos. "Notre Marengo le modèle de base vidéo fournit des informations perceptuelles, sémantiques et contextuelles à l'équipe d'évaluation de la qualité de la vidéo. PegasusNotre modèle génératif imite la façon dont les humains passent de la perception au traitement et à la logique", a expliqué M. Couture.

Tout comme le cerveau humain reçoit, interprète et organise en permanence des quantités colossales d'informations, l'IA multimodale de Twelve Labs a pour mission de synthétiser de multiples stimuli en une compréhension cohérente. Elle extrait des données de la vidéo autour de variables telles que le temps, les objets, la parole, le texte, les personnes et les actions, pour les synthétiser en vecteurs, c'est-à-dire en représentations mathématiques.

Pour ce faire, il utilise des tâches telles que la reconnaissance ou la détection d'actions, la reconnaissance de formes, la détection d'objets et la compréhension de la scène.

Parce que les applications de la compréhension holistique de la vidéo ont une portée considérable dans le domaine du suivi et de l'évaluation et au-delà, Twelve Labs propose un environnement de type "bac à sable", appelé le "système de suivi et d'évaluation". Terrain de jeux-qui permet aux utilisateurs d'explorer et de tester la technologie de compréhension vidéo. L'entreprise propose également documentation et offre une API robuste qui permet aux utilisateurs d'intégrer des capacités de compréhension vidéo dans leur plateforme en quelques appels d'API seulement.

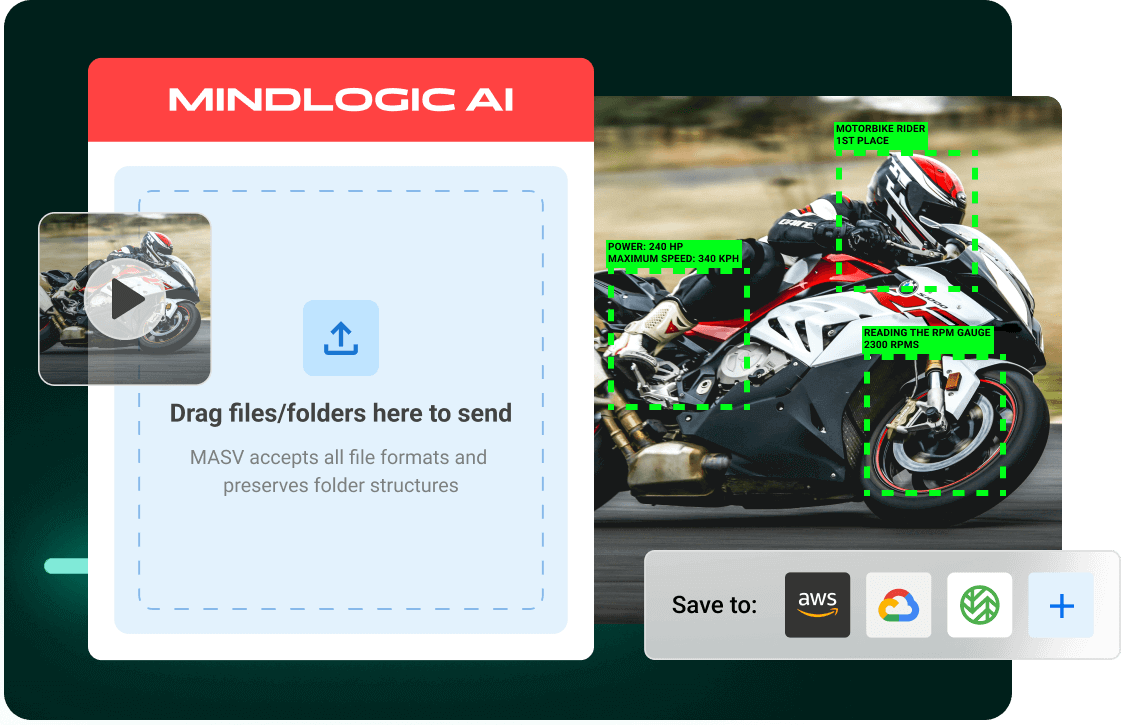

MASV et Twelve Labs permettent des flux de travail vidéo IA dans le nuage

En décembre 2023, environ 328,77 millions de téraoctets de données mondiales sont créées chaque jour, avec des vidéo responsable de 53,27 % de cette-et de plus en plus. C'est cette évolution spectaculaire et continue vers la vidéo qui rend la technologie de compréhension vidéo de Twelve Labs si importante.

MASV comprend également le potentiel déjà immense et croissant de la vidéo. Notre service de transfert rapide et sans friction de fichiers volumineux permet d'ingérer d'énormes ensembles de données dans des environnements en nuage populaires pour le traitement de l'IA, y compris Amazon S3à l'aide d'un chargeur de fichiers automatisé et sécurisé. Cela permet de simplifier l'ingestion de contenu pour prendre en charge Flux de travail d'IA impliquant la vidéo et d'autres grands ensembles de données.

Les utilisateurs peuvent configurer MASV pour qu'il télécharge automatiquement tous les fichiers transférés dans l'instance S3 de l'utilisateur, puis utiliser Twelve Labs pour accélérer les tâches de compréhension vidéo de l'IA, telles que la recherche d'archives/de contenu ou le résumé de vidéos.

Vous voulez tester MASV et Twelve Labs ? S'inscrire au MASV gratuitement dès aujourd'hui et obtenez 20 Go de données gratuites pour faire des essais - et pendant que vous y êtes, inscrivez-vous à Le terrain de jeu des douze laboratoires pour découvrir ce que le pouvoir de la compréhension vidéo peut vous apporter.

Intégrer de grands ensembles de données dans le nuage

MASV migre des ensembles de données d'entraînement vidéo dans le cloud plus rapidement que jamais pour lancer des flux de travail d'IA.