Het is geen overdrijving om te zeggen dat kunstmatige intelligentie (AI) nu overal is. Je kunt je tegenwoordig niet omdraaien zonder een nieuwe incarnatie of toepassing van AI te zien. Nergens is dat meer waar dan in de wereld van video- en filmproductie.

Van het schrijven van scripts en het scouten van locaties in de preproductie tot het verwijderen van objecten en het stabiliseren van scènes in de post, de overname van AI en machine learning (ML) is een feit. En dat is een goede zaak: minder tijd besteden aan vervelende taken betekent dat M&E-professionals geld kunnen besparen en hun kostbare tijd aan waardevollere taken kunnen besteden.

Maar misschien is een van de meest innovatieve en krachtige manieren waarop de kracht van AI brengt een revolutie teweeg in de videowereld is door video-begrip.

Dit bericht is geschreven in samenwerking met Twaalf laboratoria, een pionier op het gebied van multimodale AI voor het begrijpen van video, en is ook uitgelicht op hun blog.

Inhoudsopgave

Bestandsoverdracht voor enorme datasets

De snelste en eenvoudigste manier om grote datasets en grote videobestanden te uploaden naar de cloud voor AI-verwerking.

Wat is Video Understanding?

Video begrijpen Modellen analyseren, interpreteren en begrijpen video-inhoud en extraheren informatie op zo'n manier dat de volledige context van de video wordt begrepen.

Foto door Agentschap Olloweb op Unsplash

Het gaat niet alleen om het identificeren van objecten frame voor frame of het ontleden van de audiocomponenten. AI-gestuurd videobegrip koppelt natuurlijke taal aan de acties in een video. Om dat te kunnen doen, moet het verschillende videobegriptaken uitvoeren, zoals activiteitsherkenning en objectdetectie, om de nuance te begrijpen van wat er wordt gecommuniceerd via deze meest vloeiende media door de visuele, audio- en spraakelementen van een video te verwerken en te begrijpen.

Het verschilt ook van grote taalmodellen (LLM's) zoals ChatGPT, die niet zijn getraind om specifiek videogegevens te begrijpen.

Simpel gezegd begrijpen AI-videomodellen video net zoals wij dat doen.

Het is een enorme uitdaging, maar wel een die videobegripinfrastructuurbedrijf Twelve Labs graag aangaat.

Kunstmatige intelligentie en filmmaken

Een verkenning van de invloed van kunstmatige intelligentie op het maken van films en een analyse van de technologie.

Toepassingen van Video Understanding in Media & Entertainment

Voordat we dieper ingaan op de technologie achter deep video understanding, onderzoeken we eerst hoe video understanding het werk van M&E-professionals en makers van videocontent kan stroomlijnen.

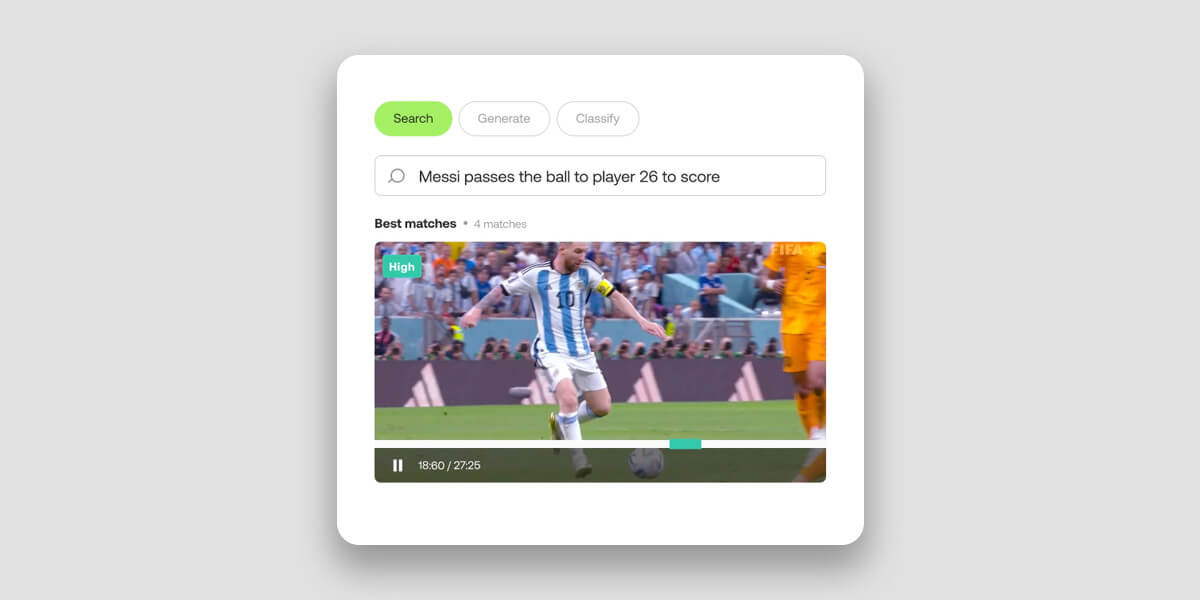

Video zoeken

Stel je voor dat je een bepaalde video kunt vinden in een enorme verzameling van petabytes aan gegevens, simpelweg door de visuele elementen in natuurlijke taal te beschrijven. Of als een sportcompetitie of clubvraagt je AI-video-begripmodel om Stel in een paar seconden een hoogtepuntreel samen van alle doelpunten van een speler.

Al deze dingen zijn mogelijk met behulp van AI-videobegrip.

Traditioneel zoeken naar video's heeft daarentegen ernstige beperkingen in zijn aanpak en uitvoering. Door voornamelijk te vertrouwen op het matchen van trefwoorden om video's te indexeren en op te halen, maken ze geen gebruik van multimodale AI-technieken die een dieper begrip van video bieden via visuele en auditieve signalen.

Door gelijktijdig alle beschikbare gegevenstypen te integreren - inclusief afbeeldingen, geluiden, spraak en tekst op het scherm - kunnen moderne modellen voor het begrijpen van video's de complexe relaties tussen deze elementen vastleggen om een meer genuanceerde, menselijke interpretatie te leveren.

Dat resulteert in veel sneller en veel nauwkeuriger zoeken en ophalen van video's uit objectopslag in de cloud. In plaats van tijdrovende en ineffectieve handmatige tagging kunnen videobewerkers natuurlijke taal gebruiken om snel en nauwkeurig enorme media-archieven te doorzoeken om videomomenten en verborgen juweeltjes op te sporen die anders misschien onopgemerkt zouden blijven.

Twaalf Labs API zoeken Het duurt ongeveer 15 minuten om een uur video te indexeren, waardoor geïndexeerde video semantisch doorzoekbaar wordt in meer dan 100 talen.

Videoclassificatie

AI-gestuurd videobegrip zorgt voor automatische categorisatie van video in vooraf gedefinieerde klassen of onderwerpen. Met behulp van Twelve Labs' API classificerenJe kunt video's indelen in sport, nieuws, entertainment of documentaires door semantische kenmerken, objecten, acties en andere elementen van de inhoud te analyseren.

Het model kan ook specifieke scènes classificerendie praktische toepassingen rond reclame of inhoudsmoderatie kunnen aandrijven. De technologie kan bijvoorbeeld op basis van de context een scène met een wapen identificeren als educatief, dramatisch of gewelddadig.

Dit komt ten goede aan makers en videoplatforms en verbetert de gebruikerservaring door nauwkeurigere aanbevelingen te doen op basis van de interesses en voorkeuren van een gebruiker. Het komt ook ten goede aan postproductie-professionals die snel items moeten vinden en vastleggen voor bewerking, archivering of andere doeleinden.

Hoewel elke video die wordt gebruikt in de technologie van Twelve Labs standaard metagegevensGebruikers hebben ook de optie om aangepaste metagegevens naar hun video's om meer gedetailleerde of contextspecifieke informatie te geven.

Van bewaking en beveiliging tot sportanalyse, van contentmoderatie tot gecontextualiseerde reclame, het begrijpen van video kan videoclassificatie volledig veranderen.

Video beschrijving

Video understanding kan een videodataset automatisch samenvatten door middel van gedetailleerde beschrijvingen die binnen enkele seconden worden gegenereerd. De technologie verbetert het begrip en de betrokkenheid door lange video's samen te vatten in beknopte weergaven die de belangrijkste inhoud bevatten.

Zulke snelle, gedetailleerde samenvattingen kunnen een grote hulp zijn bij het verrijken van media met beschrijvende metadata en samenvattingen. Vooral voor mensen met fysieke beperkingen of cognitieve beperkingen die video tot een minder ideaal medium maken.

In de media- en entertainmentindustrie kan videobeschrijving en -samenvatting worden gebruikt om previews of trailers te maken voor films, tv-programma's en andere videocontent. Deze previews geven een beknopt overzicht van de inhoud en helpen kijkers te beslissen of ze de volledige video willen bekijken. En alles wat de gebruikerservaring verbetert, is goed.

Twaalf Labs API-suite genereren genereert teksten op basis van uw video's. Het biedt drie verschillende eindpunten die op maat gemaakt zijn om aan verschillende eisen te voldoen. Elk eindpunt is ontworpen met specifieke niveaus van flexibiliteit en aanpassing om aan verschillende behoeften te voldoen.

- De Gist API kan beknopte tekstuitvoer produceren zoals titels, onderwerpen en lijsten met relevante hashtags.

- De Samenvatting API is ontworpen om video samenvattingen, hoofdstukken en hoogtepunten te genereren.

- Voor aangepaste uitgangen is de API genereren Hiermee kunnen gebruikers specifieke indelingen en stijlen kiezen, van opsommingstekens tot rapporten en zelfs creatieve teksten op basis van de inhoud van de video.

De technologie achter video begrijpen

"AI kan 80% van alle data ter wereld niet begrijpen omdat het opgesloten zit in videocontent", legt de CEO van Twelve Labs uit. Jae Lee in een interview met MASV. "Wij bouwen de sleutels om het te ontsluiten."

Bestaande computervisie (CV) modellen, die neurale netwerken en ML gebruiken om digitale beelden te begrijpen, hebben altijd moeite gehad met het begrijpen van context in video. CV-modellen zijn goed in het identificeren van objecten en gedrag, maar niet in de relatie daartussen. Deze leemte beperkte tot voor kort ons vermogen om video-inhoud nauwkeurig te analyseren met behulp van AI.

Travis Couture, de oprichter van Twelve Labs, ziet het als content versus context.

"De traditionele aanpak is om videocontent op te splitsen in problemen die gemakkelijker op te lossen zijn, wat meestal betekent dat je frame voor frame analyseert als individuele beelden en de audiokanalen apart opsplitst en daar transcriptie op uitvoert. Als die twee processen klaar zijn, breng je alles weer samen en combineer je je bevindingen.

"Als je dat doet - afbreken en opnieuw opbouwen - dan kun je het...je hebt misschien de inhoud, maar niet de context. En met video is context belangrijk.

"Het doel van Twelve Labs is om af te stappen van die traditionele computervisiebenadering en naar de arena van het begrijpen van video's te gaan, en dat betekent video verwerken zoals mensen dat doen, en dat is alles bij elkaar, alles tegelijk."

Multimodaal videobegrip

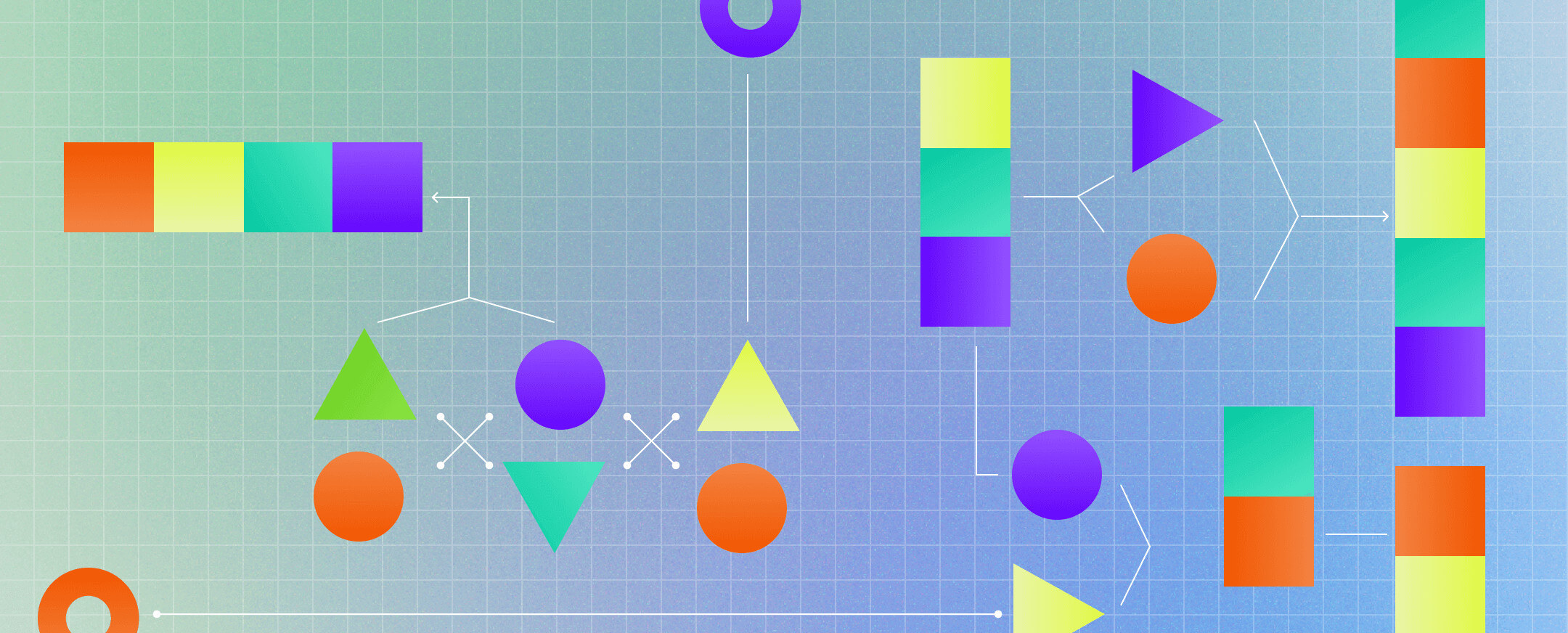

Bron: Wat is Multimodale AI?

Video is dynamisch, gelaagd, vloeiend - een combinatie van elementen die, als ze worden opgesplitst en afzonderlijk geanalyseerd, niet het geheel vormen. Dit is het probleem dat Twelve Labs heeft opgelost. Maar hoe hebben ze dat gedaan?

Door multimodale AI.

De term "modaliteit" in deze context verwijst naar de manier waarop een gebeurtenis wordt ervaren. Bij video zijn er, net als in de echte wereld, meerdere modaliteiten: auditief, visueel, temporeel, taal en andere.

"Als je die modaliteiten afzonderlijk analyseert en probeert ze weer samen te voegen", legt Twelve Labs medeoprichter en hoofd bedrijfsontwikkeling uit. Soyoung Lee"Je zult nooit holistisch begrip en context bereiken."

De multimodale aanpak van Twelve Labs heeft het mogelijk gemaakt om een model te bouwen dat de manier nabootst waarop mensen video interpreteren. "Onze Marengo video foundation model voedt perceptuele, semantische en contextuele informatie naar PegasusOns generatieve model bootst de manier na waarop mensen van waarneming naar verwerking en logica gaan," legt Couture uit.

Net zoals het menselijk brein voortdurend kolossale hoeveelheden informatie ontvangt, interpreteert en ordent, draait het bij de multimodale AI van Twelve Labs allemaal om het synthetiseren van meerdere stimuli tot een samenhangend begrip. Het haalt gegevens uit video rond variabelen zoals tijd, objecten, spraak, tekst, mensen en acties om de gegevens te synthetiseren in vectoren, of wiskundige representaties.

Het maakt gebruik van taken zoals actieherkenning of actiedetectie, patroonherkenning, objectdetectie en scènebegrip om dit mogelijk te maken.

Omdat toepassingen voor holistisch video-begrip zo verstrekkend zijn in M&E en daarbuiten, biedt Twelve Labs een sandbox-omgeving - de Speeltuin-waarmee gebruikers de technologie voor het begrijpen van video's kunnen verkennen en testen. Het bedrijf biedt ook documentatie en biedt een robuuste API waarmee gebruikers met slechts een paar API-aanroepen mogelijkheden voor het begrijpen van video's in hun platform kunnen opnemen.

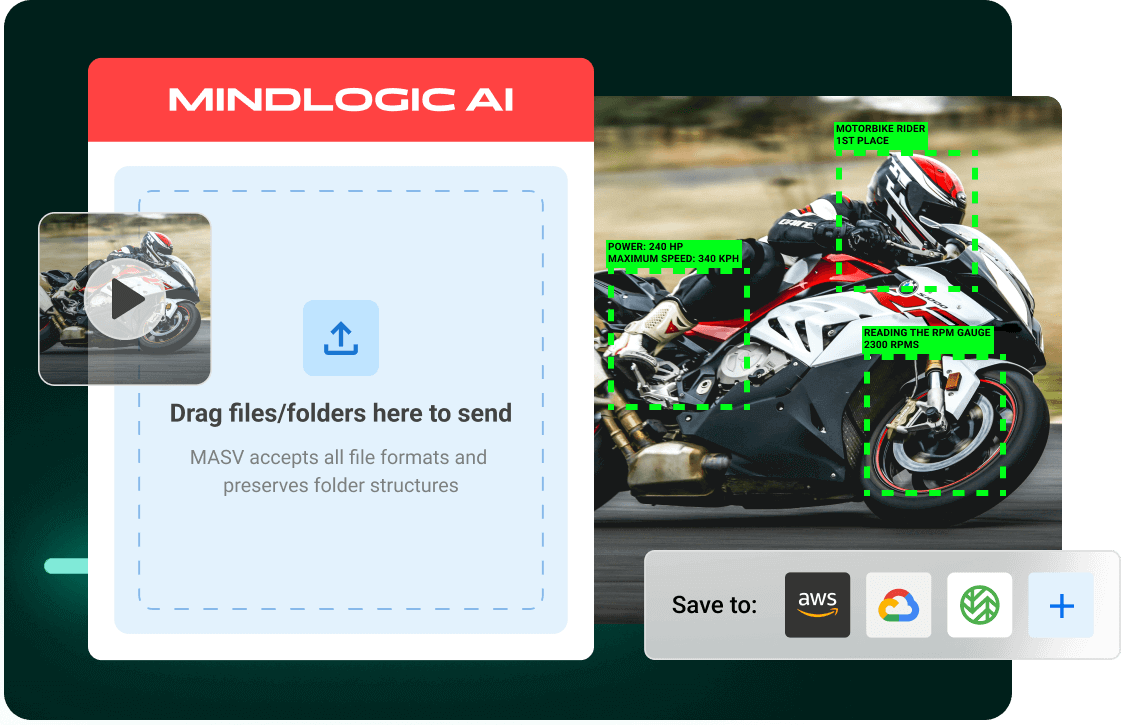

AI-videoworkflows in de cloud met MASV en Twelve Labs

Vanaf december 2023 ongeveer 328,77 miljoen terabytes van wereldwijde gegevens werden elke dag gecreëerd, met video verantwoordelijk voor 53,27 procent van dat-en stijgende. Het is deze dramatische en voortdurende verschuiving naar video die de technologie van Twelve Labs voor het begrijpen van video zo belangrijk maakt.

MASV begrijpt ook het enorme en groeiende potentieel van video. Onze wrijvingsloze, snelle service voor de overdracht van grote bestanden kan enorme datasets opnemen in populaire cloudomgevingen voor AI-verwerking, waaronder Amazon S3met behulp van een geautomatiseerde en beveiligde bestandsuploader. Dit vereenvoudigt de opname van inhoud ter ondersteuning van AI-workflows met video en andere grote datasets.

Gebruikers kunnen MASV zo configureren dat alle overgebrachte bestanden automatisch worden geüpload naar de S3-instantie van de gebruiker en vervolgens Twelve Labs gebruiken om AI-videobegriptaken te versnellen, zoals het zoeken in archieven/content of het samenvatten van video's.

Wil je MASV en Twelve Labs uitproberen? Aanmelden voor MASV vandaag gratis en krijg 20GB gratis data om dingen uit te proberen - en als je toch bezig bent, meld je dan aan voor Twaalf Labs speeltuin omgeving om te ontdekken wat de kracht van videobegrip voor jou kan betekenen.

Grote datasets opnemen in de cloud

MASV migreert videotrainingsdatasets sneller dan ooit naar de cloud om AI-workflows op gang te brengen.