No es una hipérbole decir que la inteligencia artificial (IA) está ahora en todas partes. Hoy en día no se puede dar la vuelta sin ver una nueva encarnación o aplicación de la IA. En ninguna parte es esto más cierto que en el mundo de la producción de vídeo y cine.

Desde la escritura de guiones y la búsqueda de localizaciones en la preproducción hasta la eliminación de objetos y la estabilización de escenas en la postproducción, la conquista de la IA y el aprendizaje automático es real. Y eso es bueno: al dedicar menos tiempo a tareas tediosas, los profesionales de M&E pueden ahorrar dinero y dedicar su valioso tiempo a tareas más valiosas.

Pero quizá una de las formas más innovadoras y poderosas en las que el poder del La IA está revolucionando el mundo del vídeo es a través de comprensión de vídeo.

Este post ha sido escrito en colaboración con Doce laboratoriospionera en IA multimodal para la comprensión de vídeo, y es también en su blog.

Índice de contenidos

Transferencia de archivos para conjuntos de datos masivos

La forma más rápida y sencilla de descargar grandes conjuntos de datos y archivos de vídeo de gran tamaño en la nube para procesarlos con IA.

¿Qué es la comprensión por vídeo?

Comprensión del vídeo Los modelos analizan, interpretan y comprenden el contenido del vídeo, extrayendo la información de forma que se entienda todo el contexto del vídeo.

Foto de Agencia Olloweb en Unsplash

No se trata sólo de identificar objetos fotograma a fotograma o de analizar los componentes de audio. La comprensión de vídeo basada en inteligencia artificial relaciona el lenguaje natural con las acciones de un vídeo.. Para ello tiene que realizar varias tareas de comprensión de vídeo, como el reconocimiento de actividades y la detección de objetos, para captar los matices de lo que se comunica a través de este medio tan fluido, procesando y comprendiendo los elementos visuales, sonoros y de voz de un vídeo.

También es diferente de los grandes modelos lingüísticos (LLM) como ChatGPT, que no están entrenados para comprender específicamente datos de vídeo.

En pocas palabras, los modelos de comprensión de vídeo de la IA comprenden el vídeo igual que nosotros.

Es un reto enorme, pero es uno que la empresa de infraestructura de comprensión de vídeo Twelve Labs está afrontando con entusiasmo.

Inteligencia artificial y cine

Una exploración del impacto de la inteligencia artificial en el cine, junto con un análisis de la tecnología.

Aplicaciones de la comprensión de vídeo en los medios de comunicación y el entretenimiento

Antes de sumergirnos en la tecnología que hay detrás de la comprensión profunda del vídeo, vamos a explorar exactamente cómo la comprensión del vídeo puede agilizar el trabajo de los profesionales de M&E y de los creadores de contenidos de vídeo.

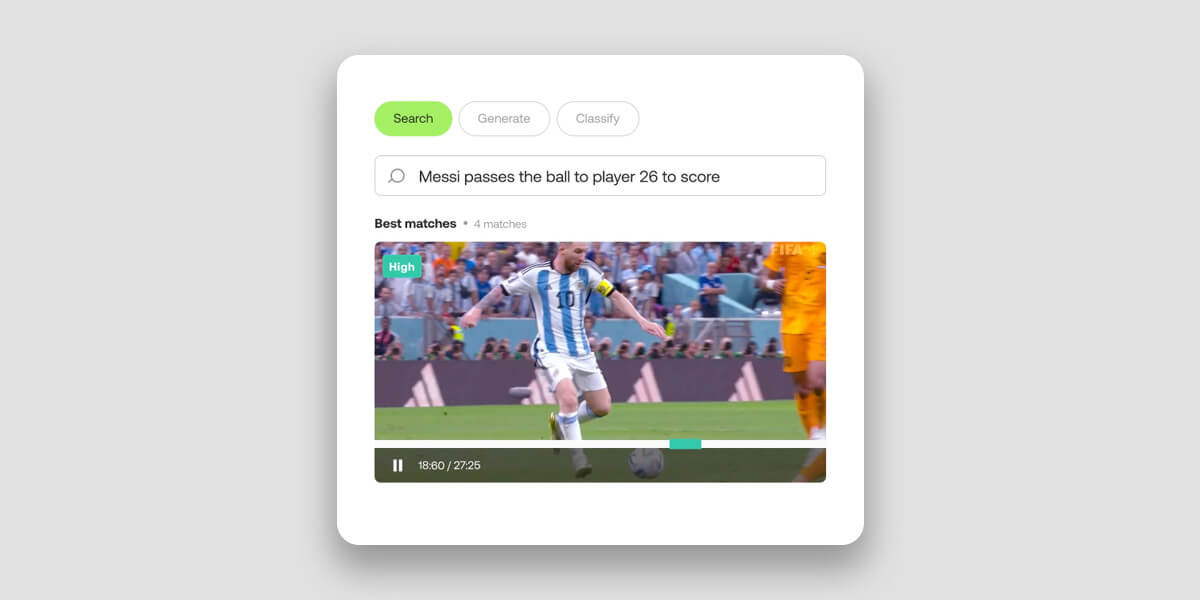

Búsqueda de vídeos

Imagine poder encontrar un vídeo concreto en una vasta colección de petabytes de datos, simplemente describiendo sus elementos visuales en lenguaje natural. O como liga o club deportivopedirle a su modelo de comprensión de vídeo que montar un vídeo con todos los goles de un jugador en unos segundos.

Todo esto es posible gracias a la comprensión de vídeo de la IA.

La búsqueda tradicional de vídeos, por otra parte, tiene graves limitaciones en su planteamiento y ejecución. Al basarse principalmente en la concordancia de palabras clave para indexar y recuperar vídeos, no aprovechan las técnicas de IA multimodal que proporcionan una comprensión más profunda del vídeo a través de pistas visuales y auditivas.

Al integrar simultáneamente todos los tipos de datos disponibles (imágenes, sonidos, voz y texto en pantalla), los modernos modelos de comprensión de vídeo captar las complejas relaciones entre estos elementos para ofrecer una interpretación más matizada y humana.

El resultado es una búsqueda y recuperación de vídeos mucho más rápida y precisa desde el almacenamiento de objetos en la nube. Los editores de vídeo pueden utilizar el lenguaje natural para realizar búsquedas rápidas y precisas en vastos archivos multimedia y desenterrar momentos de vídeo y joyas ocultas que, de otro modo, podrían pasar desapercibidas.

Laboratorios Twelve Buscar API tarda unos 15 minutos en indexar una hora de vídeo y permite realizar búsquedas semánticas en más de 100 idiomas.

Clasificación en vídeo

La comprensión de vídeo basada en IA permite categorizar automáticamente los vídeos en clases o temas predefinidos. Con la ayuda de Twelve Labs Clasificar API, puede organizar los vídeos en deportes, noticias, entretenimiento o documentales analizando las características semánticas, los objetos, las acciones y otros elementos del contenido.

El modelo también puede clasificar escenas específicasque puede impulsar aplicaciones prácticas en torno a la publicidad o la moderación de contenidos. La tecnología puede identificar una escena que contenga un arma como educativa, dramática o violenta, por ejemplo, basándose en el contexto.

Esto beneficia a los creadores y a las plataformas de vídeo, además de mejorar la experiencia del usuario al ofrecerle recomendaciones más precisas basadas en sus intereses y preferencias. También beneficia a los profesionales de la postproducción que necesitan encontrar y registrar rápidamente elementos para editarlos, archivarlos u otros fines.

Aunque todos los vídeos utilizados en la tecnología de Twelve Labs contienen metadatos estándarlos usuarios también tienen la opción de añadir metadatos personalizados a sus vídeos para ofrecer información más detallada o específica del contexto.

De la vigilancia y la seguridad al análisis deportivo, de la moderación de contenidos a la publicidad contextualizada, la comprensión de vídeo tiene la capacidad de dar un vuelco total a la clasificación de vídeos.

Descripción del vídeo

La comprensión de vídeos puede resumir automáticamente un conjunto de datos de vídeo mediante descripciones detalladas generadas en segundos. La tecnología mejora la comprensión y la participación condensando vídeos largos en representaciones concisas que captan el contenido más importante.

Estos resúmenes rápidos y detallados pueden ser de gran ayuda a la hora de enriquecer los medios con metadatos descriptivos y resúmenes. Sobre todo para las personas con discapacidades físicas o cognitivas que hacen del vídeo un medio poco idóneo.

En la industria de los medios de comunicación y el entretenimiento, la descripción y el resumen de vídeo pueden utilizarse para crear avances o trailers de películas, programas de televisión y otros contenidos de vídeo. Estos avances ofrecen una visión concisa del contenido y ayudan a los espectadores a decidir si quieren ver el vídeo completo. Y todo lo que mejore la experiencia del usuario es bueno.

Laboratorios Twelve Generar conjunto de API genera textos a partir de sus vídeos. Ofrece tres puntos finales distintos adaptados para satisfacer diversos requisitos. Cada punto final se ha diseñado con niveles específicos de flexibilidad y personalización para adaptarse a diferentes necesidades.

- El API Gist puede producir textos concisos como títulos, temas y listas de hashtags relevantes.

- El Resumen API está diseñado para generar resúmenes de vídeos, capítulos y momentos destacados.

- Para salidas personalizadas, el Generar API permite a los usuarios solicitar formatos y estilos específicos, desde viñetas a informes e incluso letras creativas basadas en el contenido del vídeo.

La tecnología detrás de la comprensión de vídeo

"La IA no puede entender el 80% de los datos del mundo porque está encerrada en contenidos de vídeo", explicó el CEO de Twelve Labs Jae Lee en una entrevista con MASV. "Construimos las llaves para abrirlo".

De hecho, los modelos heredados de visión por ordenador (CV), que utilizan redes neuronales y ML para entender las imágenes digitales, siempre han tenido problemas para comprender el contexto dentro del vídeo. Los modelos de CV son excelentes para identificar objetos y comportamientos, pero no la relación entre ellos. Se trata de una laguna que, hasta hace poco, limitaba nuestra capacidad para analizar con precisión el contenido de vídeo mediante IA.

Travis Couturearquitecto fundador de soluciones en Twelve Labs, enmarcó la cuestión en el contenido frente al contexto.

"El enfoque tradicional ha consistido en dividir el contenido de vídeo en problemas más fáciles de resolver, lo que suele significar analizar fotograma a fotograma como imágenes individuales y dividir los canales de audio por separado y transcribirlos. Una vez terminados estos dos procesos, se reunía todo y se combinaban los resultados.

"Cuando haces eso -romper y reconstruir-puede que tengas el contenido pero no el contexto. Y con el vídeo, el contexto es lo más importante.

"El objetivo de Twelve Labs es alejarse de ese enfoque tradicional de visión por ordenador y entrar en el terreno de la comprensión de vídeo, y eso significa procesar el vídeo como lo hacen los humanos, es decir, todo junto, todo a la vez."

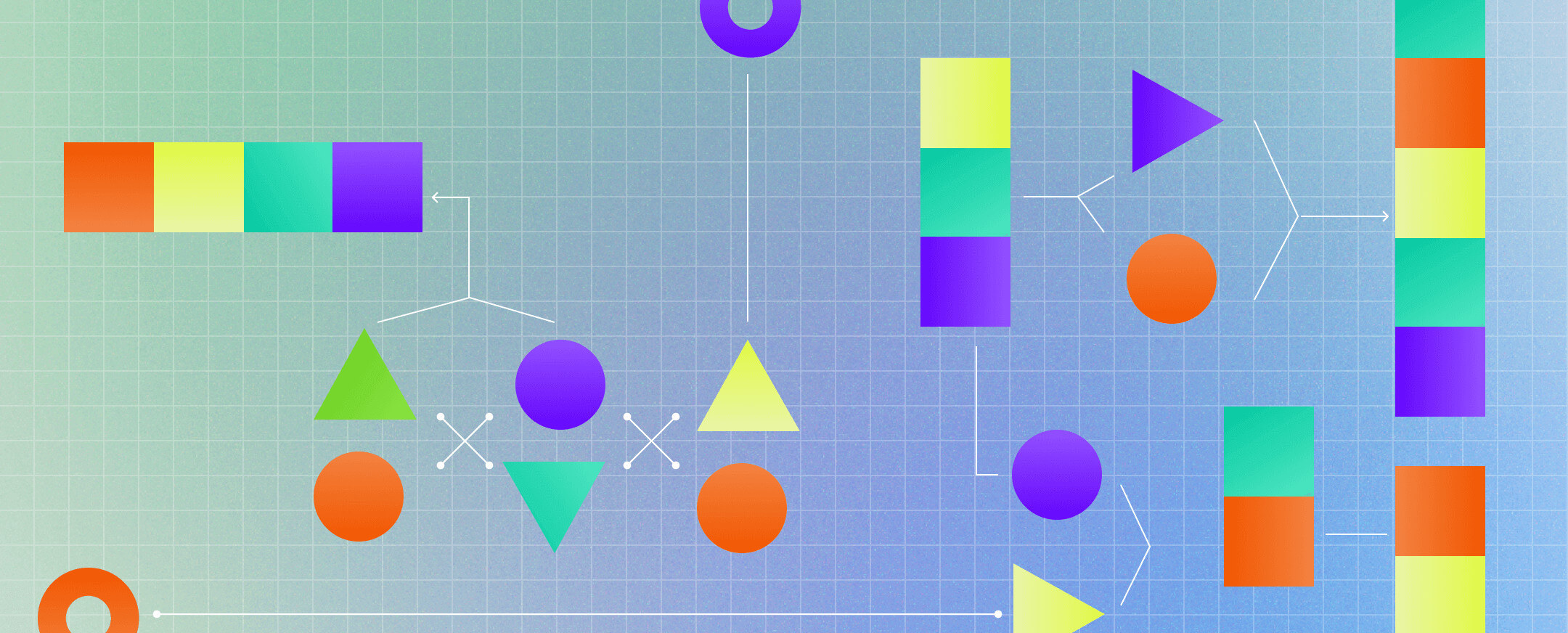

Comprensión multimodal de vídeo

Fuente: ¿Qué es la IA multimodal?

El vídeo es dinámico, estratificado, fluido: una combinación de elementos que, cuando se descomponen y analizan por separado, no suman el todo. Este es el problema que ha resuelto Twelve Labs. Pero, ¿cómo lo han hecho?

Mediante el empleo de IA multimodal.

En este contexto, el término "modalidad" se refiere a la forma en que se experimenta un acontecimiento. Con el vídeo, como en el mundo real, existen múltiples modalidades: Auditiva, visual, temporal, lingüística y otras.

"Cuando se analizan estas modalidades por separado y se intenta recomponerlas", explica el cofundador y responsable de desarrollo empresarial de Twelve Labs Soyoung Lee"nunca lograrás una comprensión y un contexto holísticos".

El enfoque multimodal de Twelve Labs le ha permitido construir un modelo que reproduce la forma en que los humanos interpretan el vídeo. "Nuestro Marengo modelo de base de vídeo alimenta información perceptual, semántica y contextual a Pegasonuestro modelo generativo, imitando la forma en que los humanos pasan de la percepción al procesamiento y la lógica", explicó Couture.

Al igual que el cerebro humano recibe, interpreta y ordena constantemente cantidades colosales de información, la IA multimodal de Twelve Labs trata de sintetizar múltiples estímulos en una comprensión coherente. Extrae datos de vídeo en torno a variables como el tiempo, los objetos, el habla, el texto, las personas y las acciones para sintetizar los datos en vectores o representaciones matemáticas.

Para ello, emplea tareas como el reconocimiento de acciones o la detección de acciones, el reconocimiento de patrones, la detección de objetos y la comprensión de escenas.

Dado que las aplicaciones de la comprensión holística del vídeo tienen un alcance tan amplio en el ámbito de la educación y la formación, Twelve Labs ofrece un entorno de pruebas denominado Parque infantil-que permite a los usuarios explorar y probar la tecnología de comprensión de vídeo. La empresa también ofrece documentación y ofrece una sólida API que permite a los usuarios integrar funciones de comprensión de vídeo en su plataforma con sólo unas pocas llamadas a la API.

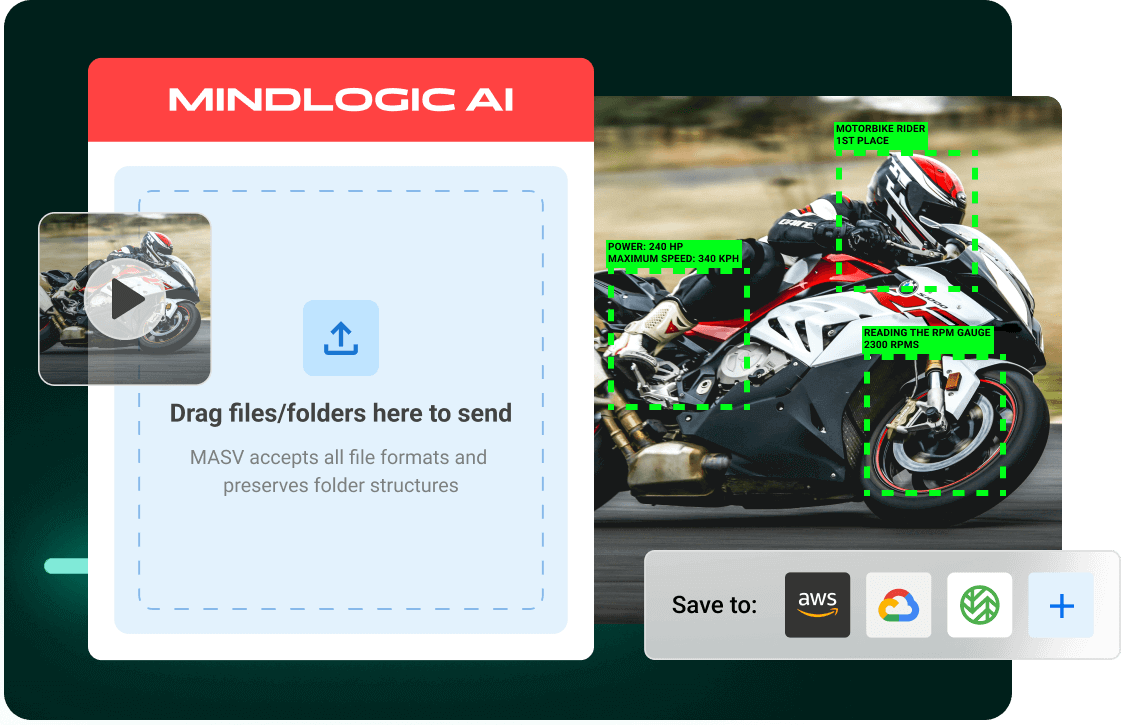

Habilitar flujos de trabajo de vídeo de IA en la nube con MASV y Twelve Labs

En diciembre de 2023, aproximadamente 328,77 millones de terabytes de datos mundiales se crean cada día, con vídeo responsable del 53,27 por ciento de ese-y en aumento. La importancia de la tecnología de comprensión de vídeo de Twelve Labs radica en este cambio drástico y continuo hacia el vídeo.

MASV también es consciente del inmenso y creciente potencial del vídeo. Nuestro servicio de transferencia de archivos de gran tamaño, rápido y sin fricciones, puede ingerir enormes conjuntos de datos en entornos de nube populares para el procesamiento de IA, incluyendo Amazon S3mediante un cargador de archivos automatizado y seguro. Esto ayuda a simplificar la ingesta de contenidos para apoyar Flujos de trabajo de IA con vídeo y otros grandes conjuntos de datos.

Los usuarios pueden configurar MASV para que cargue automáticamente cualquier archivo transferido en la instancia S3 del usuario y, a continuación, utilizar Twelve Labs para agilizar las tareas de comprensión de vídeos de IA, como la búsqueda de archivos/contenidos o el resumen de vídeos.

¿Quieres probar MASV y Twelve Labs? Regístrate en MASV gratis hoy mismo y obtén 20 GB de datos gratuitos para probarlo todo y, de paso, suscríbete a Parque infantil de Twelve Labs para explorar lo que el poder de la comprensión por vídeo puede hacer por usted.

Ingesta de grandes conjuntos de datos en la nube

MASV migra conjuntos de datos de entrenamiento de vídeo a la nube más rápido que nunca para poner en marcha flujos de trabajo de IA.