Es ist keine Übertreibung zu sagen, dass künstliche Intelligenz (KI) jetzt überall ist. Heutzutage kann man sich kaum noch umdrehen, ohne eine neue Inkarnation oder Anwendung von KI zu sehen. Nirgendwo ist das mehr der Fall als in der Welt der Video- und Filmproduktion.

Vom Schreiben von Drehbüchern und der Suche nach Drehorten in der Vorproduktion bis hin zur Entfernung von Objekten und der Stabilisierung von Szenen in der Nachbearbeitung - die Übernahme von KI und maschinellem Lernen (ML) ist real. Und das ist eine gute Sache: Weniger Zeit für langweilige Aufgaben bedeutet, dass M&E-Profis Geld sparen und ihre wertvolle Zeit für wertvollere Aufgaben verwenden können.

Aber vielleicht ist eine der innovativsten und wirkungsvollsten Möglichkeiten, wie die Macht der KI revolutioniert die Videowelt ist durch Videoverständnis.

Dieser Beitrag wurde in Zusammenarbeit mit Zwölf Laboreein Pionier der multimodalen KI für das Verstehen von Videos, und ist außerdem in ihrem Blog vorgestellt.

Inhaltsübersicht

Dateiübertragung für große Datenmengen

Der schnellste und einfachste Weg, große Datensätze und große Videodateien für die KI-Verarbeitung in die Cloud zu verlagern.

Was ist Videoverstehen?

Video-Verständnis Modelle analysieren, interpretieren und verstehen Videoinhalte und extrahieren Informationen so, dass der gesamte Kontext des Videos verstanden wird.

Foto von Agentur Olloweb auf Unsplash

Es geht nicht nur darum, die Objekte Bild für Bild zu identifizieren oder die Audiokomponenten zu analysieren. KI-gestütztes Videoverständnis ordnet natürliche Sprache den Aktionen in einem Video zu. Dazu muss es verschiedene Videoverstehensaufgaben wie Aktivitätserkennung und Objekterkennung durchführen, um die Nuancen dessen zu erfassen, was über dieses flüssigste aller Medien kommuniziert wird, indem es die Bild-, Audio- und Sprachelemente eines Videos verarbeitet und versteht.

Es unterscheidet sich auch von großen Sprachmodellen (LLMs) wie ChatGPT, die nicht speziell für das Verstehen von Videodaten trainiert sind.

Vereinfacht gesagt, verstehen KI-Videomodelle Videos genauso wie wir.

Das ist eine große Herausforderung, aber eine, die das Videoverstehens-Infrastrukturunternehmen Twelve Labs eifrig in Angriff nimmt.

Künstliche Intelligenz und Filmemachen

Eine Untersuchung der Auswirkungen der künstlichen Intelligenz auf das Filmemachen sowie eine Analyse der Technologie

Anwendungen des Videoverstehens in Medien und Unterhaltung

Bevor wir uns mit der Technologie hinter Deep Video Understanding befassen, wollen wir genau untersuchen, wie Video Understanding die Arbeit von M&E-Profis und Videocontent-Erstellern rationalisieren kann.

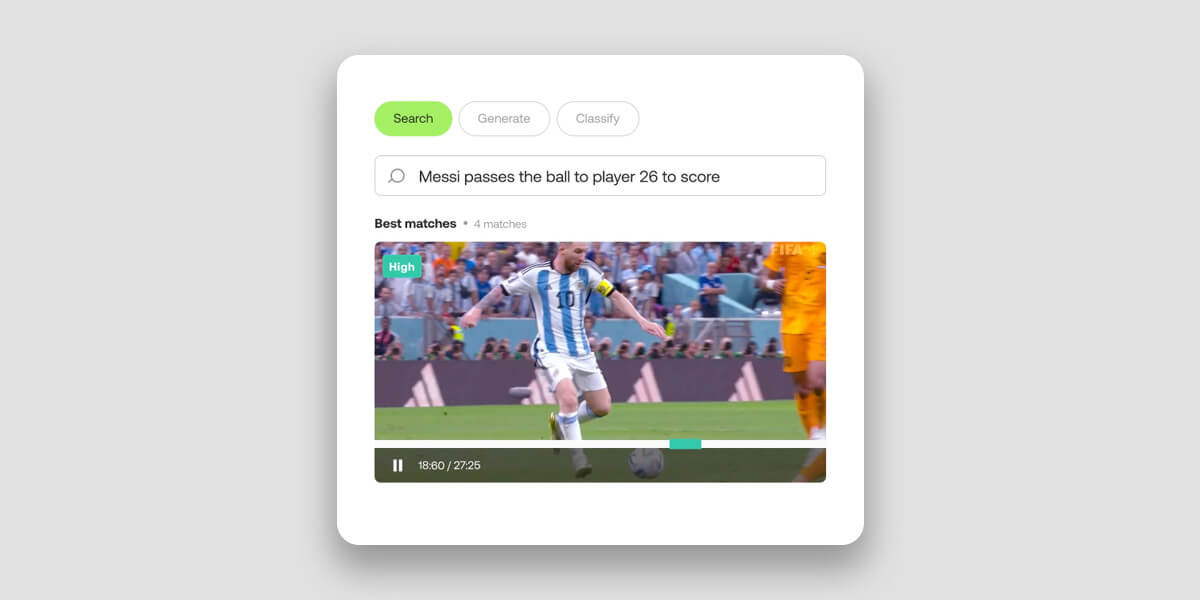

Video-Suche

Stellen Sie sich vor, Sie könnten ein bestimmtes Video in einer riesigen Sammlung von Petabytes von Daten finden, indem Sie einfach seine visuellen Elemente in natürlicher Sprache beschreiben. Oder als Sportliga oder -vereinund bitten Sie Ihr KI-Modell zum Verstehen von Videos, Folgendes zu tun in wenigen Sekunden ein Highlight-Reel mit allen Toren eines Spielers zusammenstellen.

All diese Dinge sind mit Hilfe von KI-Videobearbeitung möglich.

Die herkömmliche Videosuche hingegen weist in ihrem Ansatz und ihrer Ausführung erhebliche Einschränkungen auf. Da sie sich in erster Linie auf den Abgleich von Schlüsselwörtern stützt, um Videos zu indizieren und abzurufen, nutzt sie nicht die Vorteile von multimodalen KI-Techniken, die ein tieferes Verständnis von Videos durch visuelle und auditive Hinweise ermöglichen.

Durch die gleichzeitige Integration aller verfügbaren Datentypen - einschließlich Bildern, Tönen, Sprache und Text auf dem Bildschirm - können moderne Modelle zum Verstehen von Videos die komplexen Beziehungen zwischen diesen Elementen zu erfassen, um eine nuanciertere, menschenähnliche Interpretation zu liefern.

Das Ergebnis ist eine viel schnellere und präzisere Suche und Abfrage von Videos in Cloud-Speicherobjekten. Statt zeitaufwändiger und ineffektiver manueller Verschlagwortung können Videoredakteure mithilfe natürlicher Sprache schnell und präzise riesige Medienarchive durchsuchen, um Videomomente und verborgene Schätze zu entdecken, die andernfalls vielleicht unbemerkt bleiben würden.

Zwölf Labore Suche API benötigt etwa 15 Minuten, um eine Stunde Video zu indizieren, und macht das indizierte Video in mehr als 100 Sprachen semantisch durchsuchbar.

Video-Klassifizierung

KI-gestütztes Videoverständnis ermöglicht die automatische Kategorisierung von Videos in vordefinierte Klassen oder Themen. Mit Twelve Labs' API klassifizierenkönnen Sie Videos in Sport-, Nachrichten-, Unterhaltungs- oder Dokumentarfilme einteilen, indem Sie semantische Merkmale, Objekte, Aktionen und andere Elemente des Inhalts analysieren.

Das Modell kann auch bestimmte Szenen zu klassifizierendie praktische Anwendungen im Bereich der Werbung oder der Moderation von Inhalten ermöglichen kann. Die Technologie kann eine Szene, die eine Waffe enthält, anhand des Kontexts beispielsweise als lehrreich, dramatisch oder gewalttätig einstufen.

Dies kommt den Produzenten und Videoplattformen zugute und verbessert das Nutzererlebnis durch genauere Empfehlungen, die auf den Interessen und Vorlieben der Nutzer basieren. Auch Postproduktionsprofis, die schnell Elemente für die Bearbeitung, Archivierung oder andere Zwecke finden und protokollieren müssen, profitieren davon.

Jedes in der Technologie von Twelve Labs verwendete Video enthält Standard-Metadatenhaben die Nutzer auch die Möglichkeit, Folgendes hinzuzufügen benutzerdefinierte Metadaten zu ihren Videos, um detailliertere oder kontextspezifische Informationen zu liefern.

Von der Überwachung und Sicherheit bis hin zur Sportanalyse, von der Moderation von Inhalten bis hin zu kontextbezogener Werbung - Videoverstehen hat die Fähigkeit, die Videoklassifizierung völlig zu verändern.

Video-Beschreibung

Video Understanding kann einen Videodatensatz automatisch durch detaillierte, in Sekundenschnelle erstellte Beschreibungen zusammenfassen. Die Technologie verbessert das Verständnis und das Engagement, indem sie lange Videos zu prägnanten Darstellungen verdichtet, die die wichtigsten Inhalte erfassen.

Solche schnellen, detaillierten Zusammenfassungen können eine große Hilfe bei der Anreicherung von Medien mit beschreibenden Metadaten und Zusammenfassungen sein. Vor allem für Menschen mit körperlichen oder kognitiven Einschränkungen, die Video zu einem weniger idealen Medium machen.

In der Medien- und Unterhaltungsbranche können Videobeschreibungen und -zusammenfassungen zur Erstellung von Vorschauen oder Trailern für Filme, Fernsehsendungen und andere Videoinhalte verwendet werden. Diese Vorschauen bieten einen kurzen Überblick über den Inhalt und helfen den Zuschauern bei der Entscheidung, ob sie sich das ganze Video ansehen möchten. Und alles, was die Nutzererfahrung verbessert, ist eine gute Sache.

Zwölf Labore API-Suite generieren generiert Texte auf der Grundlage Ihrer Videos. Es bietet drei verschiedene Endpunkte, die auf die unterschiedlichen Anforderungen zugeschnitten sind. Jeder Endpunkt wurde mit bestimmten Flexibilitäts- und Anpassungsebenen entwickelt, um unterschiedlichen Anforderungen gerecht zu werden.

- Die Gist-API kann prägnante Textausgaben wie Titel, Themen und Listen relevanter Hashtags erzeugen.

- Die Zusammenfassung API ist für die Erstellung von Videozusammenfassungen, Kapiteln und Highlights konzipiert.

- Für benutzerdefinierte Ausgaben kann der API generieren ermöglicht es den Nutzern, bestimmte Formate und Stile aufzurufen, von Aufzählungspunkten über Berichte bis hin zu kreativen Texten, die auf dem Inhalt des Videos basieren.

Die Technologie hinter dem Video-Verständnis

"KI kann 80% der weltweiten Daten nicht verstehen, weil sie in Videoinhalten eingeschlossen sind", erklärt Twelve Labs CEO Jae Lee in einem Interview mit MASV. "Wir bauen die Schlüssel, um sie aufzuschließen."

Herkömmliche Computer-Vision-Modelle (CV), die neuronale Netze und ML verwenden, um digitale Bilder zu verstehen, hatten schon immer Probleme, den Kontext in Videos zu erfassen. CV-Modelle sind hervorragend in der Lage, Objekte und Verhaltensweisen zu erkennen, nicht aber die Beziehungen zwischen ihnen. Diese Lücke schränkte bis vor kurzem unsere Fähigkeit ein, Videoinhalte mithilfe von KI genau zu analysieren.

Travis Couture, Gründungsarchitekt für Lösungen bei Twelve Labs, bezeichnete das Problem als Inhalt versus Kontext.

"Der herkömmliche Ansatz bestand darin, Videoinhalte in leichter zu lösende Probleme aufzuteilen, was in der Regel bedeutet, dass man Bild für Bild als Einzelbilder analysiert und die Audiokanäle getrennt voneinander analysiert und transkribiert. Sobald diese beiden Prozesse abgeschlossen sind, würde man alles wieder zusammenführen und die Ergebnisse kombinieren.

"Wenn man das tut - abreißen und neu aufbauen -Sie haben vielleicht den Inhalt, aber Sie haben nicht den Kontext. Und bei Videos ist der Kontext entscheidend.

"Das Ziel von Twelve Labs ist es, sich von dem traditionellen Computer-Vision-Ansatz wegzubewegen und in den Bereich des Videoverstehens vorzudringen, und das bedeutet, Videos so zu verarbeiten, wie es Menschen tun, also alles zusammen, alles auf einmal."

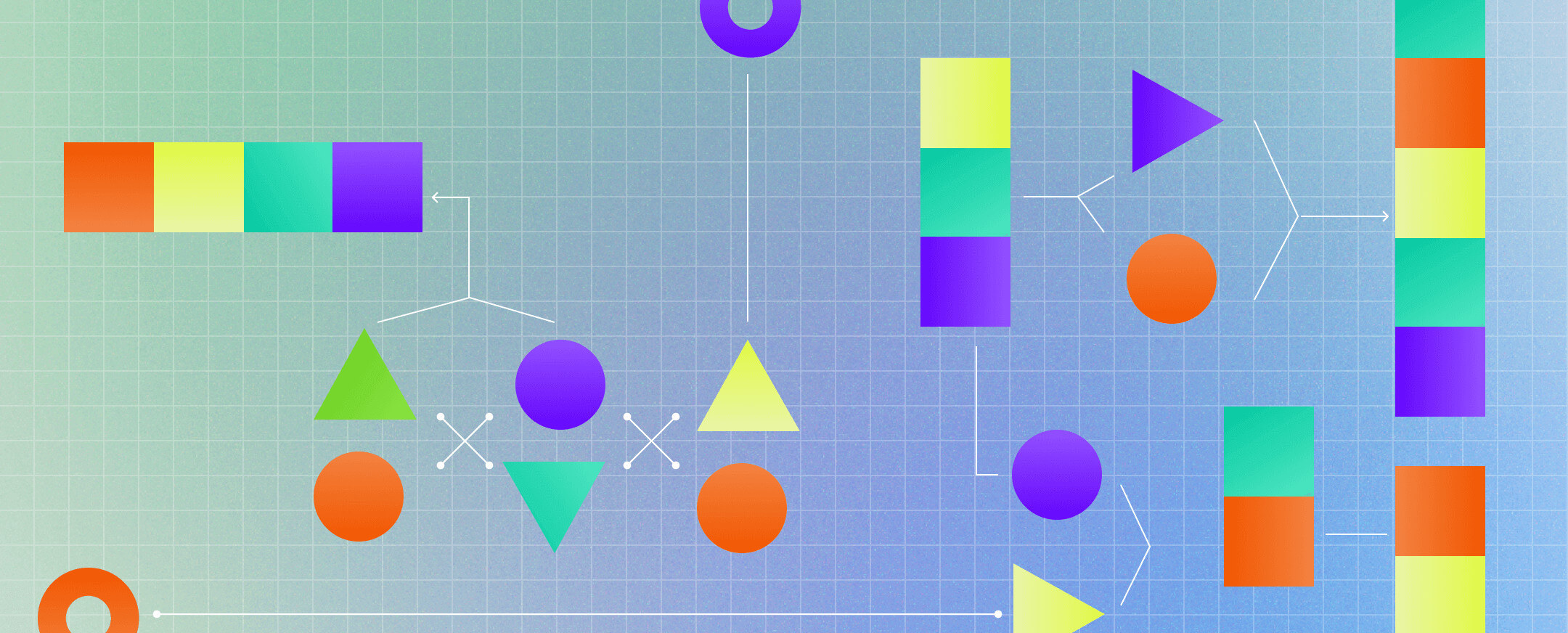

Multimodales Videoverständnis

Quelle: Was ist multimodale KI?

Video ist dynamisch, vielschichtig, fließend - eine Kombination von Elementen, die, wenn sie aufgeschlüsselt und separat analysiert werden, nicht das Ganze ergeben. Das ist das Problem, das Twelve Labs gelöst hat. Aber wie haben sie das gemacht?

Durch den Einsatz von multimodale KI.

Der Begriff "Modalität" bezieht sich in diesem Zusammenhang auf die Art und Weise, in der ein Ereignis erlebt wird. Bei Videos gibt es, wie in der realen Welt, mehrere Modalitäten: Akustische, visuelle, zeitliche, sprachliche und andere.

"Wenn man diese Modalitäten getrennt analysiert und versucht, sie wieder zusammenzufügen", erklärt Twelve Labs-Mitbegründer und Leiter der Geschäftsentwicklung Soyoung Lee"Sie werden nie ein ganzheitliches Verständnis und einen Zusammenhang erreichen".

Der multimodale Ansatz von Twelve Labs hat es ermöglicht, ein Modell zu entwickeln, das die Art und Weise nachbildet, wie Menschen Videos interpretieren. "Unser Marengo Video-Grundlagenmodell liefert Wahrnehmungs-, semantische und kontextbezogene Informationen an PegasusUnser generatives Modell ahmt die Art und Weise nach, wie Menschen von der Wahrnehmung zur Verarbeitung und Logik übergehen", erklärt Couture.

So wie das menschliche Gehirn ständig riesige Mengen an Informationen empfängt, interpretiert und ordnet, geht es bei der multimodalen KI von Twelve Labs darum, mehrere Stimuli zu einem kohärenten Verständnis zu synthetisieren. Sie extrahiert Daten aus Videos zu Variablen wie Zeit, Objekten, Sprache, Text, Personen und Aktionen, um die Daten in Vektoren oder mathematische Darstellungen zu synthetisieren.

Um dies zu erreichen, werden Aufgaben wie Handlungserkennung, Mustererkennung, Objekterkennung und Szenenverständnis eingesetzt.

Da die Anwendungen für ein ganzheitliches Videoverständnis im Bereich M&E und darüber hinaus so weitreichend sind, bietet Twelve Labs eine Sandbox-Umgebung - die Spielplatz-die es den Nutzern ermöglicht, die Technologie zum Verstehen von Videos zu erforschen und zu testen. Das Unternehmen bietet auch Dokumentation und bietet eine robuste API, mit der Benutzer mit nur wenigen API-Aufrufen Videoverstehensfunktionen in ihre Plattform einbetten können.

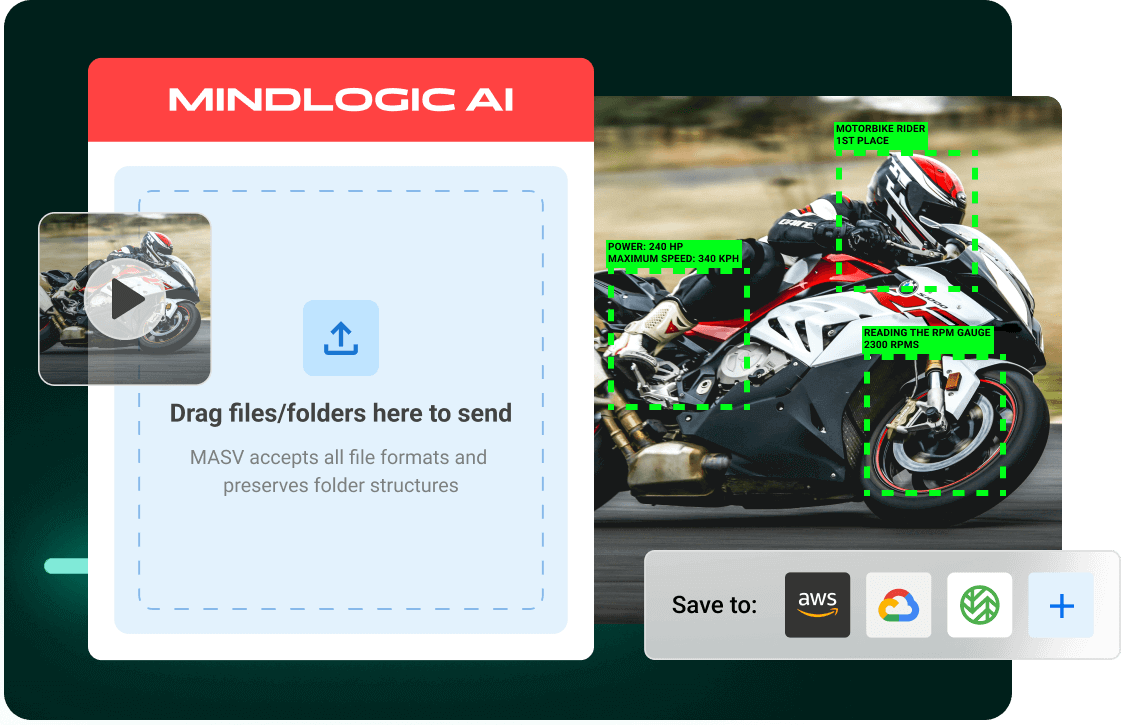

Mit MASV und Twelve Labs KI-Video-Workflows in der Cloud ermöglichen

Ab Dezember 2023 werden etwa 328,77 Millionen Terabyte von globalen Daten werden jeden Tag erstellt, mit Video verantwortlich für 53,27 Prozent dieser-... und steigend. Es ist diese dramatische und anhaltende Verlagerung hin zu Video, die die Videoverstehens-Technologie von Twelve Labs so wichtig macht.

MASV weiß auch um das bereits große und wachsende Potenzial von Video. Unser reibungsloser, schneller Service zur Übertragung großer Dateien kann riesige Datensätze in gängige Cloud-Umgebungen für die KI-Verarbeitung einspeisen, darunter Amazon S3mit einem automatischen und sicheren Datei-Uploader. Dies vereinfacht die Aufnahme von Inhalten zur Unterstützung AI-Workflows mit Video und andere große Datensätze.

Benutzer können MASV so konfigurieren, dass alle übertragenen Dateien automatisch in die S3-Instanz des Benutzers hochgeladen werden, und dann Twelve Labs verwenden, um KI-Videoverstehensaufgaben wie Archiv-/Inhaltssuche oder Videozusammenfassung zu beschleunigen.

Möchten Sie MASV und Twelve Labs auf die Probe stellen? Anmeldung für MASV und erhalten Sie 20 GB kostenloses Datenvolumen zum Ausprobieren - und wenn Sie schon dabei sind, melden Sie sich für Spielplatz der Zwölf Labore Umgebung, um herauszufinden, was die Macht des Videoverständnisses für Sie tun kann.

Aufnahme großer Datenmengen in die Cloud

MASV migriert Videotrainingsdatensätze schneller als je zuvor in die Cloud, um KI-Workflows zu starten.